LLM(大型语言模型) #

大语言模型 (英语:large language model,LLM) 是一种语言模型,由具有许多参数(通常数十亿个权重或更多)的人工神经网络组成,使用自监督学习或半监督学习对大量未标记文本进行训练。大型语言模型在 2018 年左右出现,并在各种任务中表现出色。

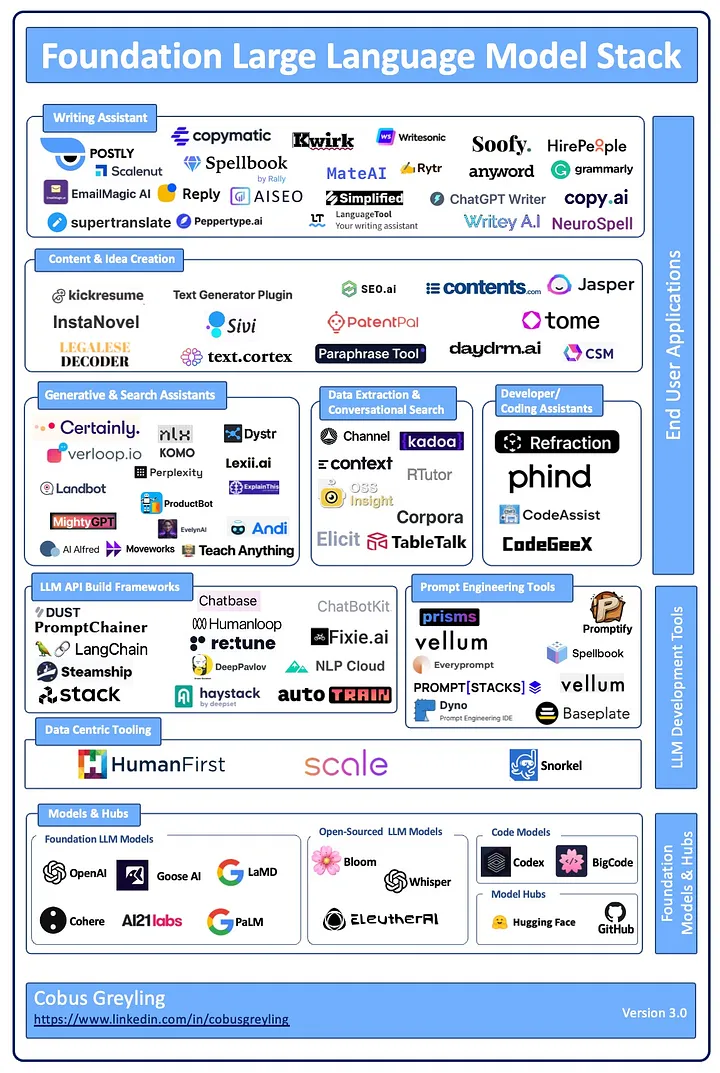

图片来自:Foundation Large Language Model Stack

开源大语言模型 #

- meta-LLaMa

- OpenLLaMA: openlm-research/open_llama

- LLaMA (

Large Language Model Meta AI) - 7B

- meta-llama/Llama-2-7b

- meta-llama/Llama-2-7b-hf

- meta-llama/Llama-2-7b-chat

- meta-llama/Llama-2-7b-chat-hf

- 13B

- meta-llama/Llama-2-13b

- meta-llama/Llama-2-13b-hf

- meta-llama/Llama-2-13b-chat

- meta-llama/Llama-2-13b-chat-hf

- 70B

- meta-llama/Llama-2-70b

- meta-llama/Llama-2-70b-hf

- meta-llama/Llama-2-70b-chat

- meta-llama/Llama-2-70b-chat-hf

- OpenLLaMA: openlm-research/open_llama

- tiiuae

- 7B

- tiiuae/falcon-7b-instruct

- tiiuae/falcon-7b

- 40B

- tiiuae/falcon-40b-instruct

- tiiuae/falcon-40b

- 180B

- tiiuae/falcon-180B

- tiiuae/falcon-180B-chat

- 7B

- THUDM

- GLM: General Language Model

- 6B

- THUDM/chatglm3-6b-base

- THUDM/chatglm3-6b

- THUDM/chatglm3-6b-32k

- THUDM/chatglm2-6b

- THUDM/chatglm2-6b-int4

- 7B

- THUDM/agentlm-7b

- 10B

- THUDM/glm-10b-chinese

- bigscience

- 560m

- bigscience/bloom-560m

- 1B

- bigscience/bloom-1b7

- 7B

- bigscience/bloom-7b1

- 3B

- bigscience/bloom-3b

- 176B

- bigscience/bloom

- 560m

- Baichuan

- 7B

- baichuan-inc/Baichuan2-7B-Base

- baichuan-inc/Baichuan2-7B-Chat

- baichuan-inc/Baichuan2-7B-Chat-4bits

- baichuan-inc/Baichuan2-7B-Intermediate-Checkpoints

- baichuan-inc/Baichuan-7B

- 13B

- baichuan-inc/Baichuan-13B-Base

- baichuan-inc/Baichuan2-13B-Base

- baichuan-inc/Baichuan-13B-Chat

- baichuan-inc/Baichuan2-13B-Chat

- baichuan-inc/Baichuan2-13B-Chat-4bits

- 7B

大模型应用工具 #

BERT #

Bidirectional Encoder Representations from Transformers

微调 #

预训练大语言模型的三种微调技术总结:

- fine-tuning

- Fine-tuning 的基本思想是采用已经在大量文本上进行训练的预训练语言模型,然后在小规模的任务特定文本上继续训练它。

- parameter-efficient fine-tuning

PEFT- 在尽可能减少所需的参数和计算资源的情况下,实现对预训练语言模型的有效微调。

- 3 种技术

- 蒸馏(

distillation),它由 Hinton 等人于 2015 年引入。该方法涉及训练一个较小的模型来模仿一个较大的预训练模型的行为。预训练模型生成“教师”预测结果,然后用于训练较小的“学生”模型。通过这样做,学生模型可以从较大模型的知识中学习,而无需存储所有参数。 - 适配器训练(

adapter training),它由 Houlsby 等人于 2019 年引入。适配器是添加到预训练模型中的小型神经网络,用于特定任务的微调。这些适配器只占原始模型大小的一小部分,这使得训练更快,内存需求更低。适配器可以针对多种任务进行训练,然后插入到预训练模型中以执行新任务。 - 渐进收缩(

progressive shrinking),它由 Kaplan 等人于 2020 年引入。这种技术涉及在 fine-tuning 期间逐渐减小预训练模型的大小。从一个大模型开始,逐渐减少参数的数量,直到达到所需的性能。这种方法可以产生比从头开始训练的模型性能更好的小型模型。

- 蒸馏(

- prompt-tuning

- 只修改模型的输入,不需要大量计算资源

参考:预训练大语言模型的三种微调技术总结:fine-tuning、parameter-efficient fine-tuning 和 prompt-tuning

叶王 © 2013-2024 版权所有。如果本文档对你有所帮助,可以请作者喝饮料。